Dans l’industrie, différents outils de mesure et de contrôle commande coexistent pour traiter les données. Ces technologies ont évolué pour se spécialiser en 4 familles : superviseur, historiseur, dataviz et data analytics. Lesquels choisir et installer ? Pour quels usages ? Avec quels bénéfices ? Sont-ils complémentaires ? Vertuoz Industri.e vous explique.

4 technologies utiles pour la performance énergétique de votre usine

Pour faire des économies d’énergie sans investissement, il est essentiel de disposer des bons outils de collecte, de traitement et d’analyse de données. Ces technologies sont déjà présentes ou à portée de main ! Vertuoz Industri.e vous en donne la liste.

Utilisez un Superviseur pour piloter votre installation

1/ Le superviseur est un système d’acquisition des données, un dispositif de télérelève en temps réel, qui va fournir une image de l’usine, son « état de santé », à l’instant présent. Grâce à cette image, les techniciens pourront contrôler le bon fonctionnement opérationnel des process et conduire l’installation.

Complétez avec un Historiseur

2/ L’historiseur permet de stocker de très grandes quantités de données non traitées de l’usine, enregistrées à l’heure, la minute, la seconde, voire à la milliseconde… durant des années ! Il va ainsi constituer le « carnet de santé » de l’usine.

Appuyez-vous sur la visualisation des données puis sur leur analyse pour améliorer le fonctionnement de votre installation

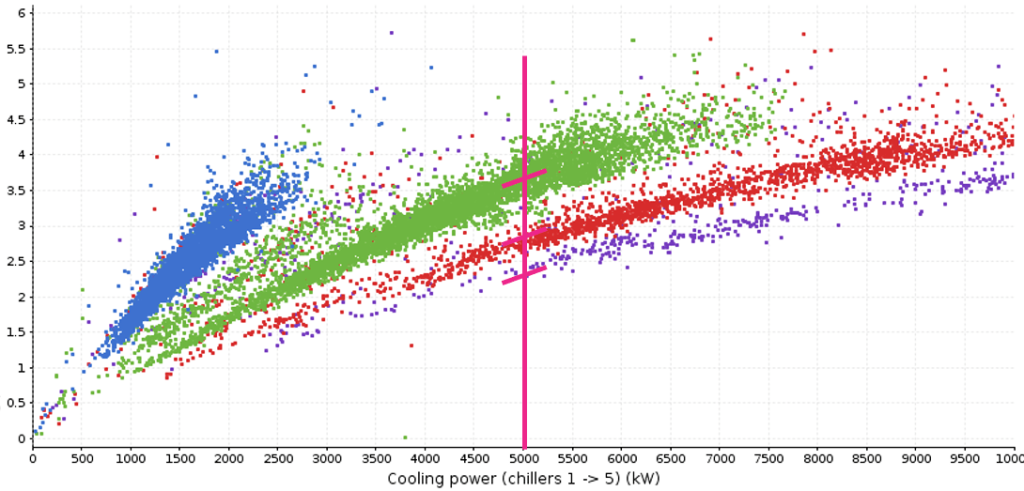

3/ La visualisation de données ou Dataviz « fait parler » les données, à l’aide de représentations graphiques, en deux – voire trois – dimensions. Car si une image vaut 1 000 mots, une représentation graphique vaut bien 100 000 données ! La dataviz s’appuie sur les moyens informatiques modernes afin de mettre en forme les données complexes de manière simple, didactique et pédagogique. Pour les Energy Managers, et d’autres métiers opérationnels, c’est une véritable aide à la compréhension et un guide précieux à la décision.

4/ L’analyse de données ou Data Analytics est une approche qui vise à améliorer la compréhension de l’installation. Elle s’appuie sur des outils statistiques et de recherche opérationnelle dont l’application est permise par l’informatique et le Big Data. Les exploitants et les Energy Managers peuvent, avec cet outil, identifier les variables ou paramètres influents et prendre des décisions de pilotage éclairées.

Ces outils peuvent fonctionner isolément dans les usines. Néanmoins, certaines plateformes de pilotage et d’optimisation énergétique, comme la solution Vertuoz Industri.e, présentent les rôles complémentaires de visualisation et d’analyse des données, permettant d’améliorer la performance des usines. L’historiseur, de son côté, peut servir de socle à ces deux fonctions. Il joue un rôle d’accélérateur des projets d’amélioration continue parce qu’il met à la disposition des briques data visualisation et data analytics un stock de données, mais ce n’est pas un prérequis. Une plateforme peut fonctionner sans historiseur, à condition de la connecter suffisamment en amont pour recueillir les données nécessaires. Certaines comme Vertuoz Industri.e comportent même une fonction d’historisation. En cumulant différentes briques dans une même plateforme, les outils s’enrichissent les uns les autres. Sur un incinérateur, un industriel nous a confié qu’il obtenait en une heure les mêmes résultats d’analyse qu’en une semaine avec un tableur, grâce aux outils de visualisation graphique de Vertuoz Industri.e»