Les groupes froids peuvent être complexes à opérer, surtout lorsqu’ils sont couplés entre eux et connectés à une ou plusieurs tours de refroidissement. Leurs performances énergétiques sont en effet étroitement liées à l’efficience de leurs sous-systèmes (compresseurs, pompes, échangeurs, évaporateurs…) ayant chacun un rendement nominal et optimal… Ils sont également extrêmement dépendants de leur environnement (tours de refroidissement, pompes de distribution, réseau, etc). Passons en revue quelques solutions pour en améliorer les performances énergétiques.

Avant d’agir : instrumenter pour mesurer le COP global

B.A.-BA de la démarche d’optimisation, le monitoring des groupes froids et des tours de refroidissement est un préalable à toute action correctrice. Il s’agit non seulement de déterminer le COefficient de Performance de chaque groupe et tour (via des mesures de débit, de température d’entrée et de sortie, et de consommation électrique) mais surtout de construire un COP global, intégrant les pompes de distributions, les auxiliaires, les consommations des tours aéroréfrigérantes, et tenant compte de la rigueur climatique (température et hygrométrie). L’idéal étant bien sûr de construire un historique de données d’une année afin de couvrir toutes les saisons et un maximum de conditions de production.

1- Investir dans une nouvelle technologie de production de froid

Les groupes les plus récents, à paliers magnétiques, sont particulièrement performants avec un COP atteignant aisément 7 ou 8 (contre 3 ou 4 pour un compresseur classique). Ces groupes froids sont très modulables et ne perdent pas en efficacité car ils contiennent plusieurs petits compresseurs qui démarrent en cascade. Ils sont en revanche très coûteux. En absence de budget, l’ajout de variateurs de puissance sur les compresseurs et pompes existants peut améliorer significativement les consommations.

Potentiel de gains : de 20 à près de 50 %

2- Ajouter un stockage tampon

L’ajout d’un réservoir de froid au niveau du by pass permet de faire travailler le compresseur essentiellement à son régime nominal, et de réduire le besoin de pointe. C’est donc une alternative aux cascades de groupes froids, qui offre également une meilleure stabilité électrique à l’échelle de l’usine. Un stockage très volumineux permet même d’optimiser les horaires de production de froid en fonction des contrats d’énergie.

Potentiel de gains : 5 % – 10 %

3- Changer d’énergie

Les groupes froids à absorption ont pour principe de « faire du froid avec du chaud »[1]. Si l’usine a par ailleurs des besoins importants en chaleur, il peut être intéressant d’implanter une centrale tri-génération : chaleur au gaz, production d’électricité conjointe, et récupération d’une partie de la chaleur fatale par un groupe froid à ab/adsorption. L’énergie électrique du compresseur, principale consommation des groupes froids classiques, disparaît alors carrément de l’équation !

Potentiel de gains : Dépend du contrat d’exploitation de la cogénération

4- Ajouter du « free cooling »

Lorsque les conditions climatiques le permettent suffisamment souvent, l’ajout d’échangeurs passifs à l’air libre (en général sur le toit de l’usine), permet de s’affranchir de l’usage des tours de refroidissement, et des consommations associées.

Potentiel de gains : 5 % – 15 %

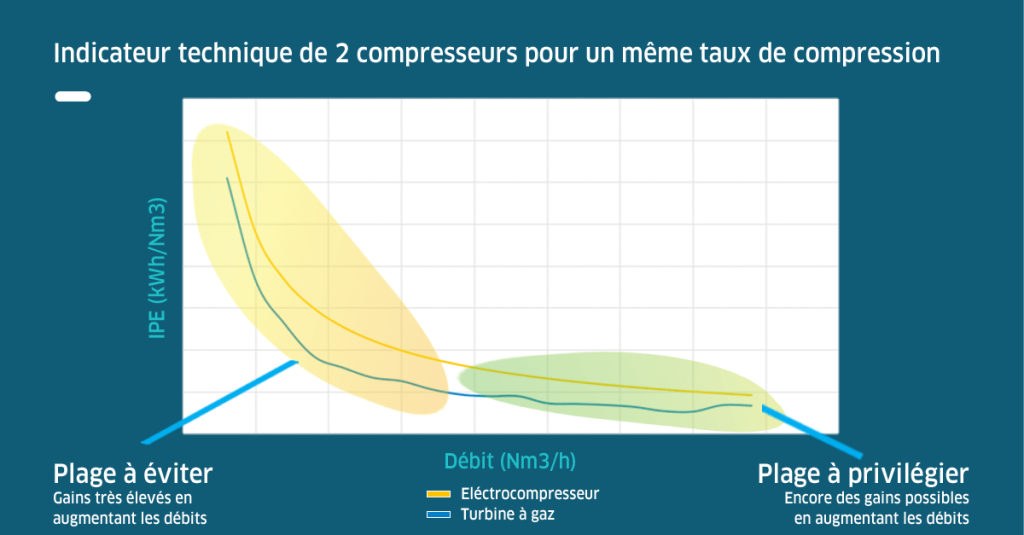

5- SANS CAPEX : Optimiser les cascades d’engagement

Dès que plusieurs groupes travaillent en parallèle se pose la question de la meilleure combinaison (leurs puissances et performances pouvant être différentes) ainsi que du bon moment pour les démarrer. En s’appuyant sur leurs caractéristiques techniques (courbes de rendement, puissance, débits…) et sur l’historique de données, il est possible de construire des règles d’engagement basées sur des critères objectifs : débit dans le by pass, conditions atmosphériques, plan de production… Ces cascades prennent également en compte les performances des tours de refroidissement et leurs contraintes techniques (nombre, vitesse, délais de démarrage…).

Potentiel de gains : 10 % – 20 %

6- SANS CAPEX : Modifier les « set points »

L’analyse des données offre régulièrement des découvertes contre-intuitives, généralement liées à des effets systémiques : « L’optimum global ne résulte pas des optima locaux » explique l’expert Jean Vielle dans Factor.e (Ed#3 : « De l’importance d’une approche systémique »). Concrètement, il arrive fréquemment qu’en augmentant légèrement la consommation d’une tour aéroréfrigérante (simplement en diminuant sa température de consigne), on réduise encore plus celle des compresseurs des groupes froids. L’étude des bons réglages nécessite un solide travail sur les données et des tests en grandeur nature.

Potentiel de gains : 5 % – 10 %

7- (Presque) SANS CAPEX : Essayez la HP flottante

Benjamin Franklin n’a pas seulement fait voler des cerfs-volants les jours d’orage. Avant de fonder les USA, il démontra par son expérience « le bouillant de Franklin », qu’une faible pression réduit la température d’ébullition d’un liquide. C’est le principe de la HP flottante : réduire la haute pression du compresseur en fonction de la température extérieure (donc surtout en hiver) pour économiser des « bars » inutiles. L’achat d’un module de régulation spécifique est cependant nécessaire.

Potentiel de gains : 5 % – 15 %

Ainsi, avec ou sans investissement, rapidement ou avec un historique assorti de quelques études sur les données énergétiques, les solutions pour optimiser la consommation énergétique de votre production de froid s’avèrent variées. Leur efficacité sera d’autant plus importante que votre SIE (Système d’Information Énergétique) est complet.

[1] Une bonne explication ici :

https://www.energieplus-lesite.be/index.php?id=11175#c6324+c6325+c6328